前言

最近有个需求,能够对不同排版格式的繁体信息进行抽取,所以从传统的版面分析+文字检测、识别+阅读顺序+NLP到现在发展的多模态大模型综合调研。

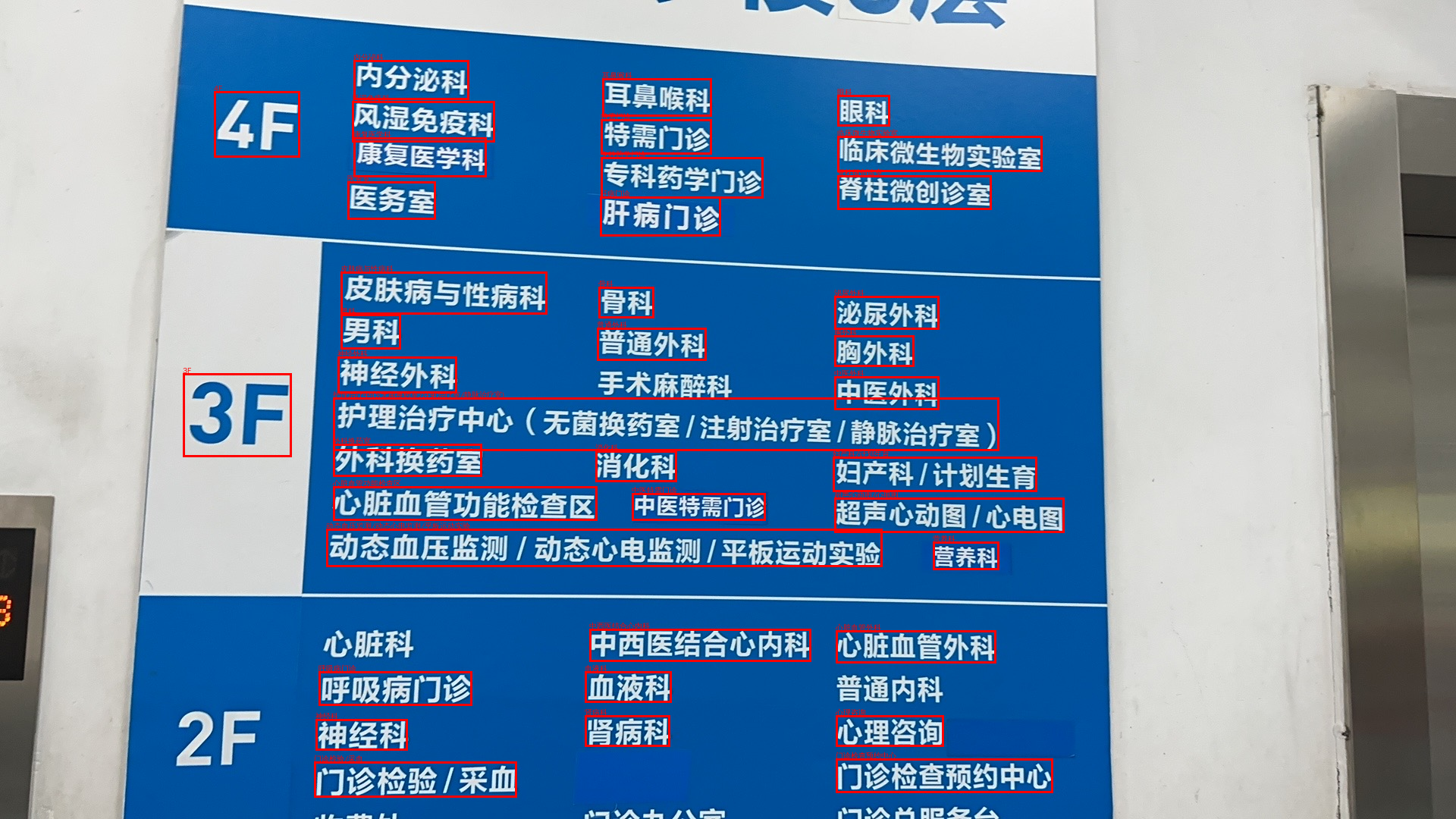

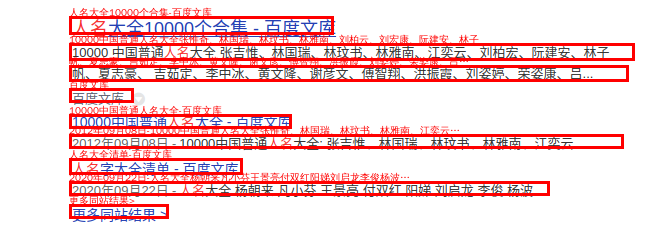

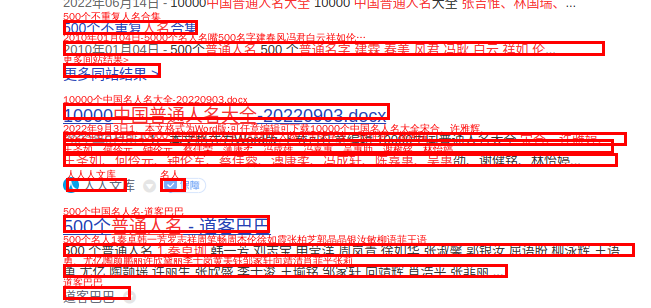

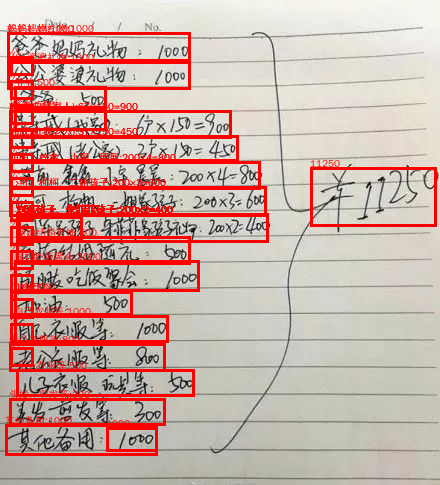

此处以文字区域检测+识别做个demo,来直观感受多模态大模型的结果。

总结

- LVLM(large vision language model)相比LLM至少落后一代。

- LVLM相比LLM更具有挑战性。1)多模态信息融合。2)从结果上看,训练时长与loss下降速度。3)高清图片,针对不同尺寸的图片,原来例如CLIP使用固长224*224像素来patch,Qwen-VL-Chat使用448,MiniCPM-V-2_6采用动态计算切分方式,来更好贴近原始SigLIP的输入尺寸,减少缩放后图片质量的损失。以及引入query embed来减少高清图片输入长度过长问题,看Perceiver Sampler和LlaVA-UHD。

- 存在更为明显重复生成问题。之前在试字节豆包时,在一个问答中涉及批量工作场景时遇到过重复生成,即模型“宕机”了,不断重复一段文本。其他LLM也有这类问题,只是相比LVLM更少些。在未见过的或者说更为复杂排版场景时,出错的概率更高。

- 推理速度。不过这个也是跟随业界大环境走吧,第一代的LLM其实速度也不是很快,后面VLLM等加速推理框架、其他技术出现等。

附件

注:实际比下面还复杂些,此处只做简单demo展示。

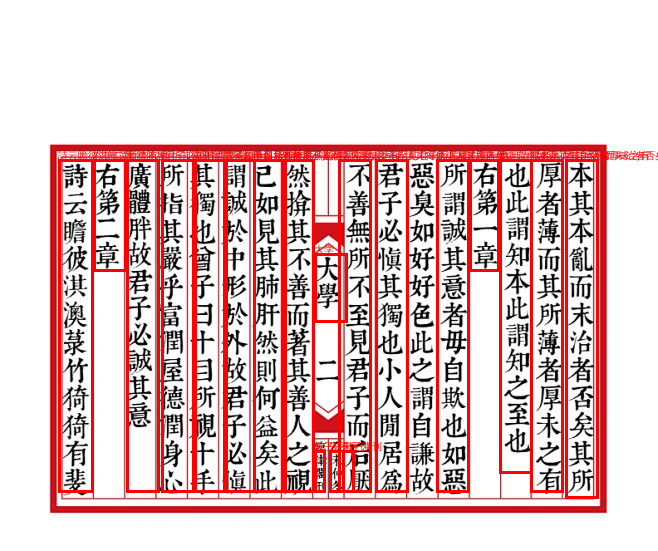

简体横排(没有这样训练语料仍能泛化,模型本身具备OCR能力):

|

|

|---|

|

|

|---|

手写体(基本仍符合横排):

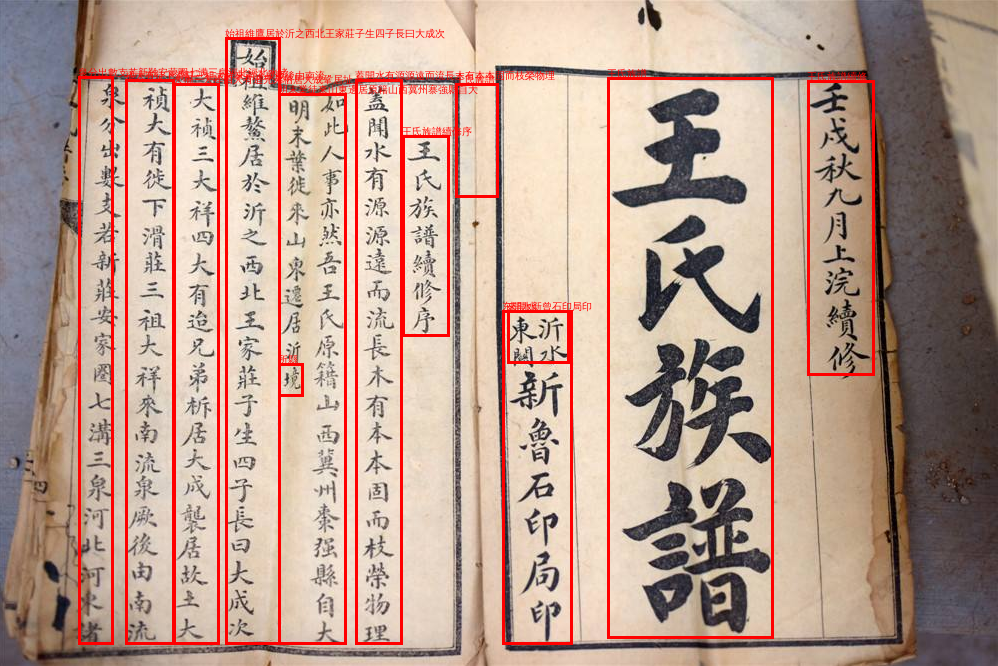

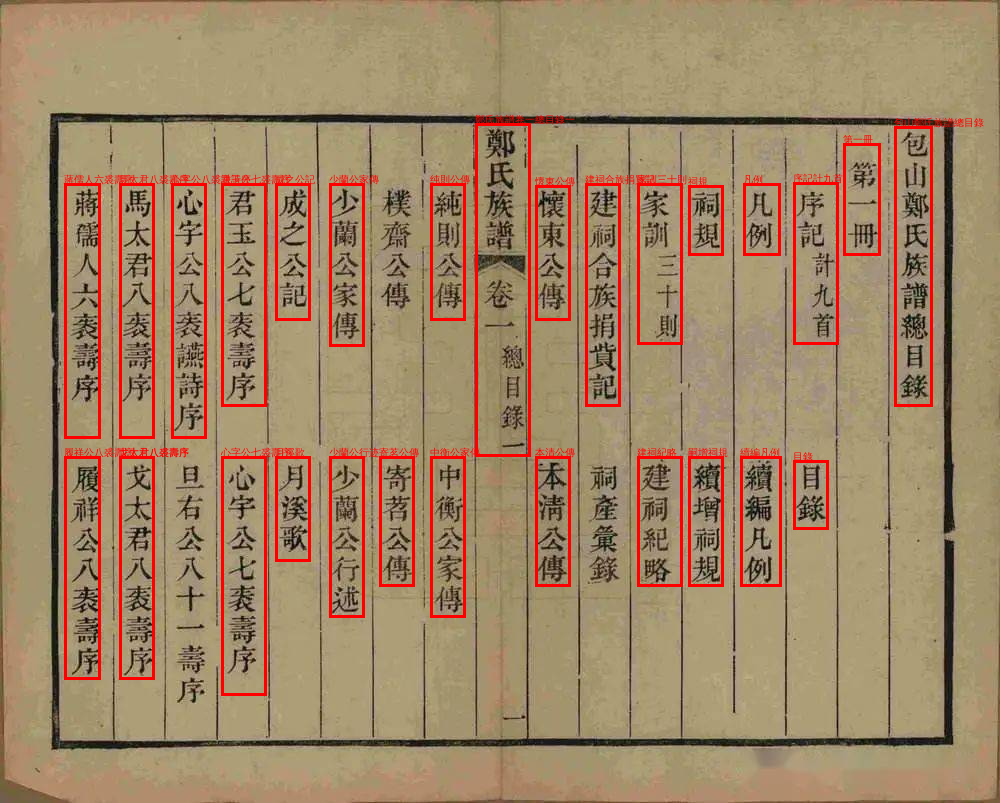

繁体竖排:

|

|

|---|

|

|---|

对于更复杂场景的排版,泛化效果不理想,官方解释是原始训练语料包含少。