安全的Python3沙箱——eval

很早之前从 reddit 看到过有人吹 eval(expr.replace('__', ''), {'__builtins__': None}, {}) 这个写法其实很安全,当年没人能攻破沙箱。我这个水平肯定是不肯能了,现在有AI了,让 opus-4.6-thinking 试了下 The classic escape chain needs object.__subclasses__() → find a class with __init__.__globals__['os'] → os.system(). Every step past info disclosure is blocked: Vector Why it fails str.format() calling methods..

更多isomorphic-git 实现 sparse checkout & commit

去年9月手搓了套blog评论系统 - req4cmt,可能是全世界很少见通过 git repo 文件本身存储评论内容,而不是 github issue。 git repo 文件 append 内容涉及到一个性能问题:repo作为整体,也就是历史所有全体评论,被 fetch, commit , push 的成本太高。如果只能修改其中的一个文件就好了。这就是 sparse checkout。git底层早就支持了,git 命令在2020年之后2.25.0+支持,但是 Cloudflare Worker 没法执行命令,也没文件系统,于是召唤AI跟我一起折腾。 大概用的这个 prompt: 核心目的是避免 clone 整个repo!! 注意在 cloudflare worker 上跑。和nodejs有点差别。 ..

更多

上手gitea actions记录

Gitea Actions CI/CD 实战:从构建到部署不久前发现我部署的 drone CI/CD 报错了 docker api 版本过低,找到一个相关的 issue,但是没有解决,另外感觉 drone 这一套貌似维护不太活跃。于是寻找一个替代方案,正好发现 Gitea 支持了 actions,于是尝试把本地部署迁移到 gitea actions,因为我本地已经部署了一个 gitea。 上手首先需要一个 self-hosted 的 Gitea,这部分略过。 接下来,我们需要配置 Gitea Actions 的执行环境,也就是 Runner。Gitea 的 Runner 叫做 act_runner,它负责执行在 workflow 文件中定义的任务。 Runner 配置解析为了让我们的 CI/CD 流程顺利..

更多编程就是玩泥巴

编程就像拿起一块泥巴,慢慢地把它捏成你想要的形状。在这个过程中,你与媒介和材料的亲密接触,会教会你你正在创造的东西——它的特性、容忍度与局限——即便你在创造的同时才逐渐理解它。你对你想做的东西,最不了解的时刻,恰恰是刚开始动手的那一刻。那时,你以为自己知道想做什么。而正是通过反复迭代的过程,你才会明白自己真正想要创造的是什么——无论一开始你是否意识到这一点。设计不仅仅是解决问题,更是发现真正需要解决的问题,然后去解决它。我们常常失败,并非因为没能把问题解决好,而是因为我们解决了错误的问题。 当你跳过创造的过程,你用一件“你以为自己想要的东西”的影子,交换了原本可以在实践中学到的真正造物经验。被直接交付一件近似你设想的成品,就剥夺了那种发现与学习的本能——这是任何真正创作实践的核心。唯有从泥块开始亲手塑造的..

更多西双版纳/海南自驾游-计划版

Foreword 原计划是从深圳自驾往返西双版纳,把沿途的一些城市和景点顺路串起来,玩一圈。 我不喜欢寒冷,所以春节这个时间点,海南和西双版纳天气差不多,只是西双版纳早晚比较冷,中午比较热,海南则是一整天都比较合适,这两个地方都可以选择去自驾一下。 趣兜风 自驾最大的麻烦,就是所有路线、节奏、景点都要自己规划。想着能不能偷个懒,就去翻了一圈市面上的自驾类 APP,看能不能直接「抄作业」——要么自动规划,要么用别人现成的路书。 这类 APP 里,比较常见的就是「趣兜风」「趣自驾」「xx路书」。趣兜风 算是功能相对完整的:可以用 AI 生成路线,也可以配置一些偏好,选项稍微多一点。不过这类功能基本都要会员,好在会员也不用正价买,咸鱼上搞个一周的就行。 实际试下来,生成的路书和可调的选项还是太少。自..

更多

2025游戏短评

Foreword 又到了一年一度短评环节 Steam 自建的 2025 年游戏回顾 https://s.team/y25/kwqdrkq?l=schinese 今年游玩 今年一共玩了 30 款游戏,比去年还少一些,七成都是新游戏。今年还是太忙了,加上练车、弄一些其他的事,游戏时间就偏少了。 大江湖之苍龙与白鸟 这游戏刚出时就遇到更换发行商,导致一直跳票,本来是和大侠同时期的游戏,一直拖到了大侠都出DLC了,这游戏才出正式版。 整体不错,没想到 24 年竟然有人做出来当年金庸群侠传的感觉,味道比神仙醋做的更正宗,文本确实可以,不过也有点可惜,游戏本可以做得更好的,运营宣发经历了很多变数导致游戏实际销量不行。有些设定过于 old school 了,如果可以重新稍微改变一下数值,升级..

更多AI搞不懂人称代词

陪娃学英语,由于我没啥耐心,于是找了豆包跟他陪练。课程是New Concept English Book I Lesson 140(是的很old school),大概内容是: A提问: Are you tired? B没听清:What does he want to know C转述:He wants to know if you are tired. 我把课本截图给豆包,豆包很快明白这一课讲的是啥,我的prompt是:豆包你扮演A和B,我回答C,你指出我的语法错误之后换别的问题继续问我。 这样进行得很顺利,直到豆包问了这样一个问题: A: What can i do for you B: What does she want to know? C: ___ 甲:我能帮你干点啥不? 乙:她问的啥来着? ..

更多

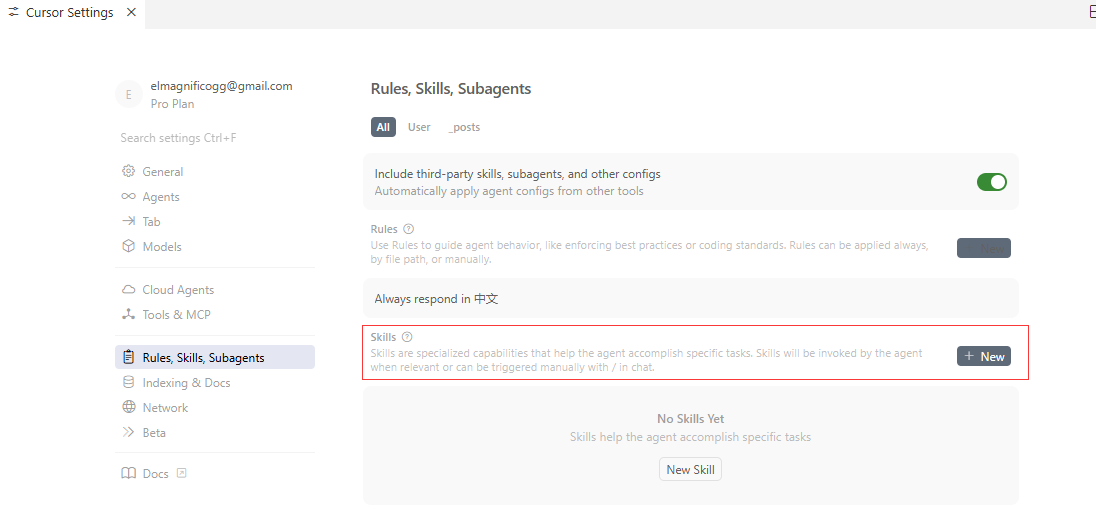

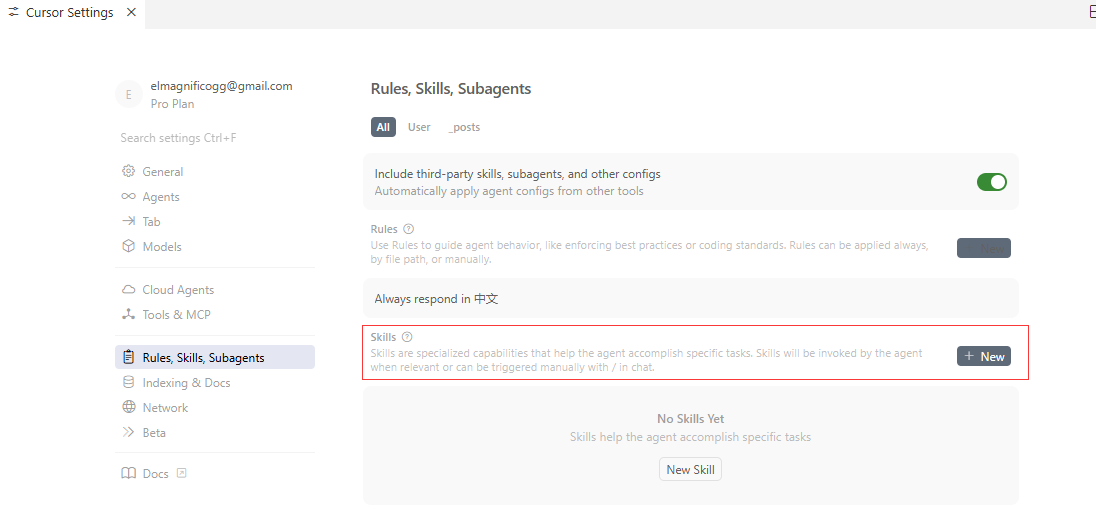

Agent Skills实践

Foreword 最近 Skills 稍微有点火,哪哪都是在讨论。这里我也结合一下日常工作的实际场景来实践一下,看看 Agent Skills 能干些啥,以及它和之前说过的 MCP 有什么区别。 Skills https://github.com/anthropics/skills Skills是由Anthropic提出的,官方给了开源的skills的模板,很快就接入了其他各大模型 核心概念 Agent Skills 是一个用于为 AI 智能体扩展专门能力的开放标准。Skills 会把特定领域的知识和工作流封装起来,智能体可以调用这些 Skills 来执行对应的任务。 大白话解说:Skills 就是把平常我们命令 AI 去做的一些「复合模板 + Prompt + 规则」的事情,收敛成..

更多今日被AI拷打

群里朋友发了一个AI拷打的prompt。做完了一轮觉得没啥,要睡觉了后劲来了。必须得记录些什么。这狗日的语言模型蹦几个金句是真的让人印象深刻 我一直有个毛病是 fear of loss,损失厌恶。 AI提醒我,我能不能用一个必不后悔的方式,先占位? 其实它这句说得有点绕,我觉得更进一步应该说,不能以我当下的情况去评估可能的风险,而是假设将来回头看,会不会为没能冒险感到后悔? 然后又聊到人际关系,我觉得最难处的就当官的和小人。AI提醒我,处处留痕才能克小人。我恍然大悟,原来官僚流程才是小人克星。啊这。😂 反而理解当官的为啥不喜欢“讲真话”,而是要讲权责,讲先例,讲文件,讲上级态度。能打败官僚的只能抬出更多的规定、流程和制度 🤣 我又问,遇到满嘴仁义道德胡搅蛮缠,不讲事实不讲道理的人怎么办,AI这么说..

更多Linux服务器各类“面板”

一直习惯手动敲,想尝试下各种面板 Redhat 的 Cockpit The following NEW packages will be installed: cockpit cockpit-bridge cockpit-networkmanager cockpit-packagekit cockpit-storaged cockpit-system cockpit-ws cracklib-runtime dconf-gsettings-backend dconf-service dns-root-data dnsmasq-base glib-networking glib-networking-common glib-networking-services gsettings-desktop-sche..

更多