LLM的弱点——不能很好的讲笑话?

元旦节长途旅行,无聊,我问娃,AI的弱点是什么?答:没有嗅觉,这个的确是物理限制,我之前吹的。哈哈哈。AI has no taste 🤣 这一路为了打法无聊时光,下载安装了个豆包闲聊。娃很喜欢猜历史人物。我发现一个规律,豆包似乎在缩小3、4次范围之后,就会进入 “你想的是不是XXX” 这种点菜名儿模式,而不是想办法进一步缩小范围。 这种模式如果是猜常见人物,那么特别准。如果是猜冷门、模糊的的,就容易 miss。 AI这种 hit or miss,让我不禁联系到不知道哪里看到过一个大佬的说法,现阶段LLM有个弱点,训练的时候给 next token “回答正确” 的单一结果给的权重太高,比如让AI讲一个 joke,它便老是翻来覆去讲那一个最擅长最经典的,就像是背题背出幻觉了。 不能很好的讲笑话,难道是LL..

更多

小米珠海官方赛道日与Ultra年度之夜

Foreword 小米官方赛道日 报名 小米Zic是12.15开抢,果不其然没抢到,还好群里有老哥抢到了不去,刚好就换成了我 抢名额是真的恶心,一共就60个名额,42秒就抢完了 活动日程,这日程排得是真紧张,一点空隙都没有 这次多了一个晚宴,晚宴同时进行模拟器比赛,晚宴还好可以后续再补付费,不然晚宴去不了还挺遗憾的 赛前整备 17号小米官方就发了赛轮88折的轮胎券,总算等到了买了2个265,2个325的新胎 之前用的卫途P01,算了一下,之前大概跑了六七个飞行圈,剩下的轮胎估计还能跑个2节,可能不太够,所以还是换了一对新胎上去,后轮磨损不明显,就没换。 又加购了2个轮毂,这样就有一套265+325的轮胎轮毂了,后续日程就能换成普通长续航胎长期用了,需要下赛道就换赛..

更多

使用Elasticsearch分析腾讯云EO日志

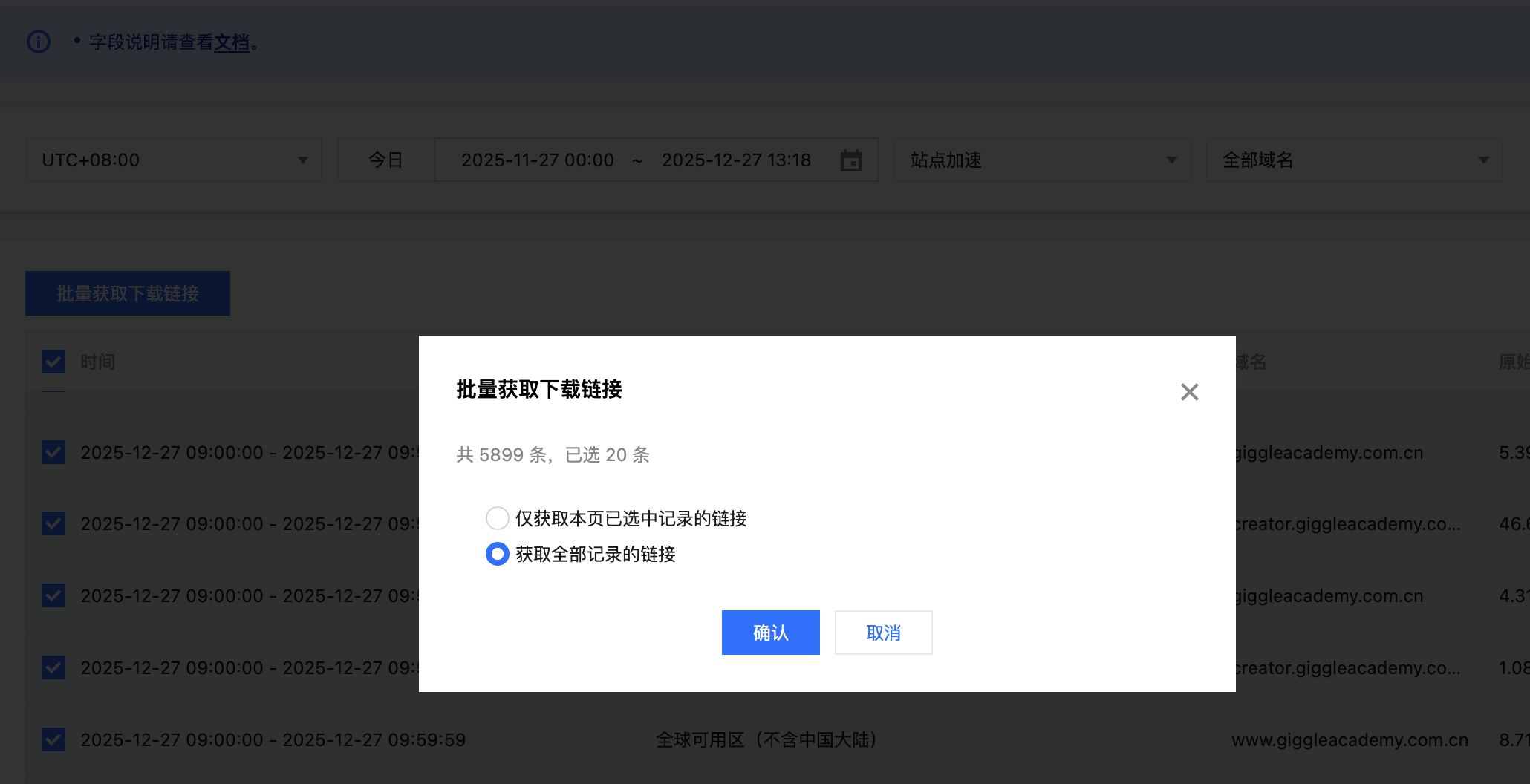

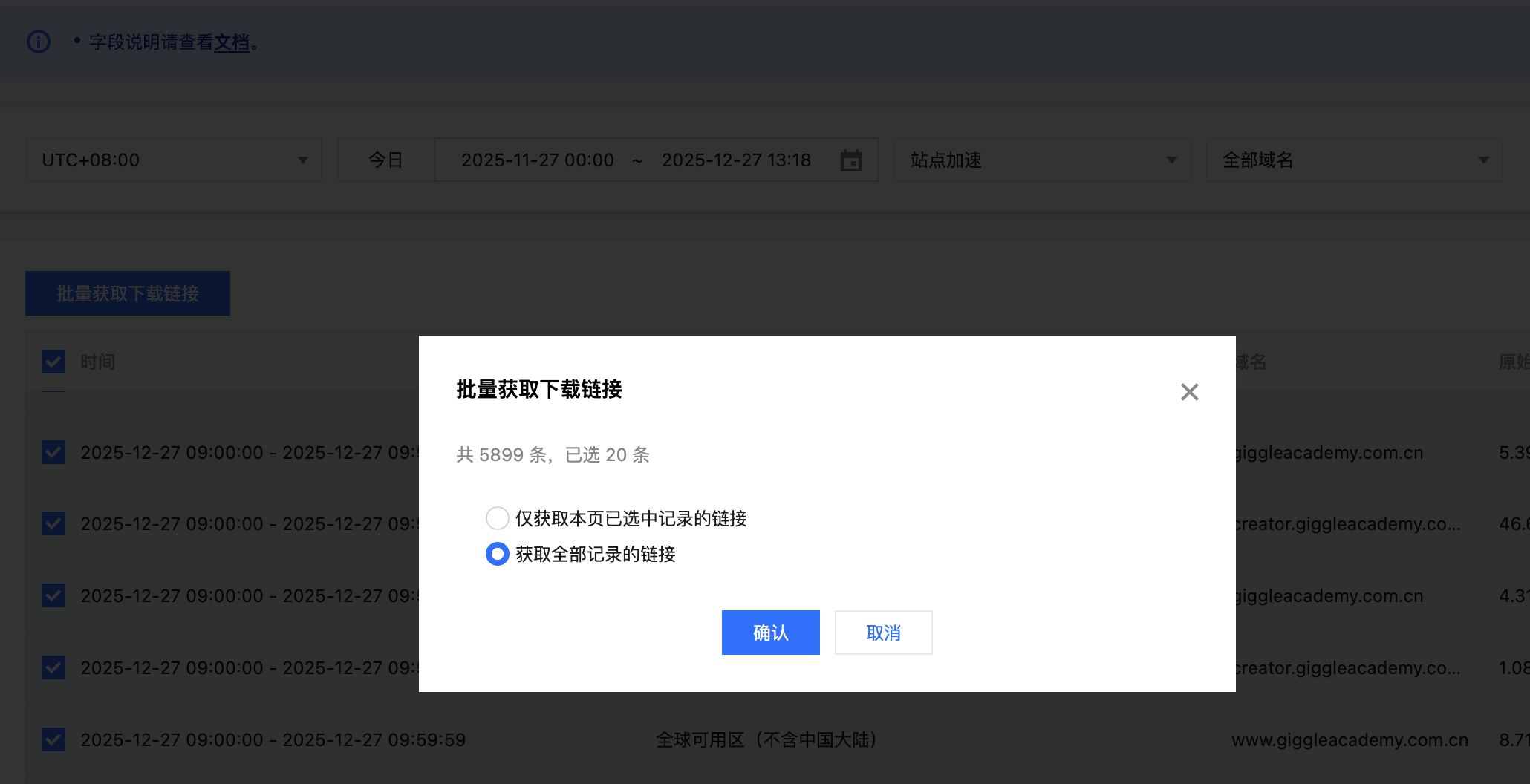

腾讯云EO可以查看一些指标信息,但是更加详细的信息需要我们下载离线日志自行分析。获取日志下载链接腾讯云会将日志打包为.gz格式,解压后文件会包含多行,每一行都是一个JSON格式的数据,对应一条EO的请求日志,日志格式可以参考腾讯云文档。我们可以批量获取最近一个月的日志下载链接之后复制所有链接并保存到urls.txt文件中。启动Elasticsearch集群我们参考官方文档使用docker来启动集群,首先下载.env和docker-compose.yml,之后在.env文件中设置es和kibana的密码都是123456,然后设置STACK_VERSION=9.2.3。考虑到数据量比较大,可以提高容器的内存大小,我这里设置了一台8G。12345678910111213141516171819202122232..

更多

“缸中之脑” 被我破解了

最近epic送了《Hogwards Legacy》我打通关了,作为原著党,十分着迷这部小时候的经典,在美轮美奂的想象世界骑扫帚,看冥想盆里剧情故事,都十分有趣。 昨天晚上加班到很晚,晚饭吃得玩,睡得更晚,肚子有点涨,早上做了非常奇怪的梦,一直吃东西,然后不小心把坐牙给弄掉出来了。感觉嘴里一阵穿堂风: 图片由ChatGPT生成,十分还原。梦里的这颗牙齿就是带着蓝色静脉和红色动脉线条。奇怪吧 出于本能,我赶紧咬合了一下,确认是不是真的掉牙齿了。结果一咬发现坐牙都还在。大脑瞬间崩溃,bia~ji 一下给我整醒了。 一看时间:06:40 tnnd。感觉没睡够,于是倒头又想重新入睡。大脑里突然闪现出 哈利波特 通过冥想盆看别人故事VR,又突然想到以前的经典电影《黑客帝国》,越想越睡不着。脑子里绷出来一件事: 缸中..

更多gpt5.1 释义意大利、乌克兰国歌歌词

之前 ChatGPT释义意大利国歌歌词 还是 gpt-3.5,得到的答案有点模糊,主要是不会用,还你一句我一句聊天呢。 现在提词也用得多了,知道怎么敲打AI 才能获得想要的结果了。 prompt写: 用中英双语一句一句翻译下面的歌词,每一句都面向无背景的读者解释其含义,以及历史渊源 Fratelli d'Italia (Inno di Mameli) ... (贴上歌词全文 回答: 这首歌是意大利国歌《Fratelli d’Italia》,又称《Inno di Mameli》,写于 1847 年,处于意大利民族复兴运动 Risorgimento 的时代。 《Fratelli d’Italia》(马梅利之歌)逐句翻译与解释 第一节 Fratelli d'Italia Brothers of I..

更多

Finale 3D与FWsim 烟花设计软件

Foreword 体验一下目前烟花领域比较主流的两款设计软件:Finale 3D 和 FWsim。它们都可以算是偏烟花方向的 SFX 设计工具。之前折腾过一些偏灯光的舞美软件,里面多少带了一点烟花模块,但基本都是“顺带做做”,专业度一般。 这次就专门来看看,真正以烟花为核心的专业软件,发展到了什么程度。 Finale 3D https://finale3d.com/ 3D 模拟烟花效果,所见即所得,大致能力包括: 支持 3D 模型导入 支持地图导入 支持音频时间码,同步时间 支持自定义烟花效果模型 内置烟花库 看起来整体价格也还算友好,不是那种完全摸不到的级别。 注册激活以后虽然不能保存和导出成正式工程,但对于单纯体验、研究格式、看工作流,已经够..

更多

懂车帝珠海赛道日与小米深圳总部参观

Foreword 最近参加的活动和改车内容 废旧回收 不得不说认识大哥还是有不少好处的,蹭了不少大哥淘汰的东西 全新卫途P01R,半价不到就卖了 2个赛轮PT01,265前胎,也是半价就给我了 2个赛轮PT01半圈,325后胎+定制轮毂,5000收到手 之前升级了刹车,又去换了轮胎,基本上把明显短板补齐了,下赛道更有信心了 小米的Club会员,存胎服务还真是好用,刚好3套轮胎,一套街胎,一套练习胎,一套刷成绩的,刚好用完小米的存胎上限,后续小米再出官方赛道日送的赛轮圈还能买,而且不计算配额,就4套胎可以换着玩。 目前还差2个265的轮毂,这样就可以快速换胎,不然一套轮胎每次要弄三四个小时,还是很麻烦的 懂车帝赛道日 报名 群里无意间看到了懂车帝的赛道日,还挺不错的,..

更多

神力科莎赛车模拟进阶

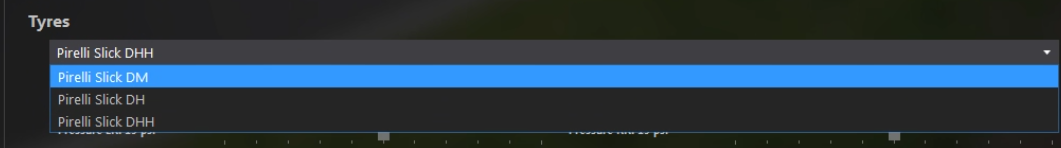

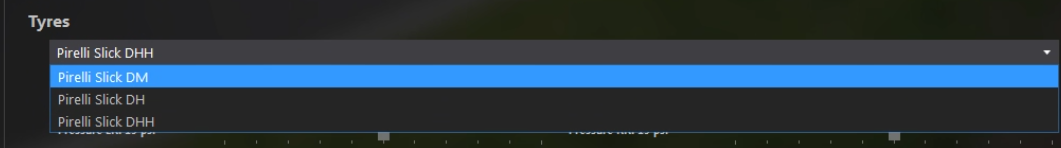

Foreword 神力科莎的车辆配置,前面玩的时候都用默认,后来发现实际上这里有些选项可能是要调整的,调整以后可能车速会快很多,这种一般都是针对一个赛道做一个配置 车辆配置 轮胎选择 CM中轮胎可能会有这么几个选项 Pirelli 是倍耐力轮胎,Slick是光头胎,也就是轮胎表面无花纹、沟槽的意思 D表示是干地,W是湿地,对应适合的地面条件 DS,S 是 Soft,DS 也是软胎,适合低速、短时间需要最大性能的赛道,磨损很快 DM,M是Medium,DM轮胎是倍耐力赛车光头胎系列中的一种,专为追求极致速度和性能的赛车设计。其配方较软,允许的工作温度较高,接触面积大,能在每个刹车和转弯中带来明显优势,适合新手 DH,..

更多

关于AI Agent处理大量第三方集成的思路

问题来源在典型的AI Agent系统中,其工作流程是一个迭代循环(AI Agent参考):LLM根据任务需求选择并调用一个工具,观察返回结果,然后基于新信息进行下一步思考和决策。 随着一个AI Agent的功能(tools)越来越多,便会出现上下文压力:每一个工具的定义(包括其名称、功能描述、参数列表和格式)都需要在输入(Prompt)中详细说明,以便LLM能够理解和使用。当集成的工具从几个增加到几十甚至上百个时,上下文长度会随着增加,新增的tool还可能会影响现有的已经调优好的tool。 思路:统一的CLI工具设计一种基于现有command_executor(假设我们的AI Agent具有执行shell命令的工具)的扩展方案。该方案引入一个名为agent-magic-tool的"虚拟"命令行工具,将所有..

更多

iMa知识库体验

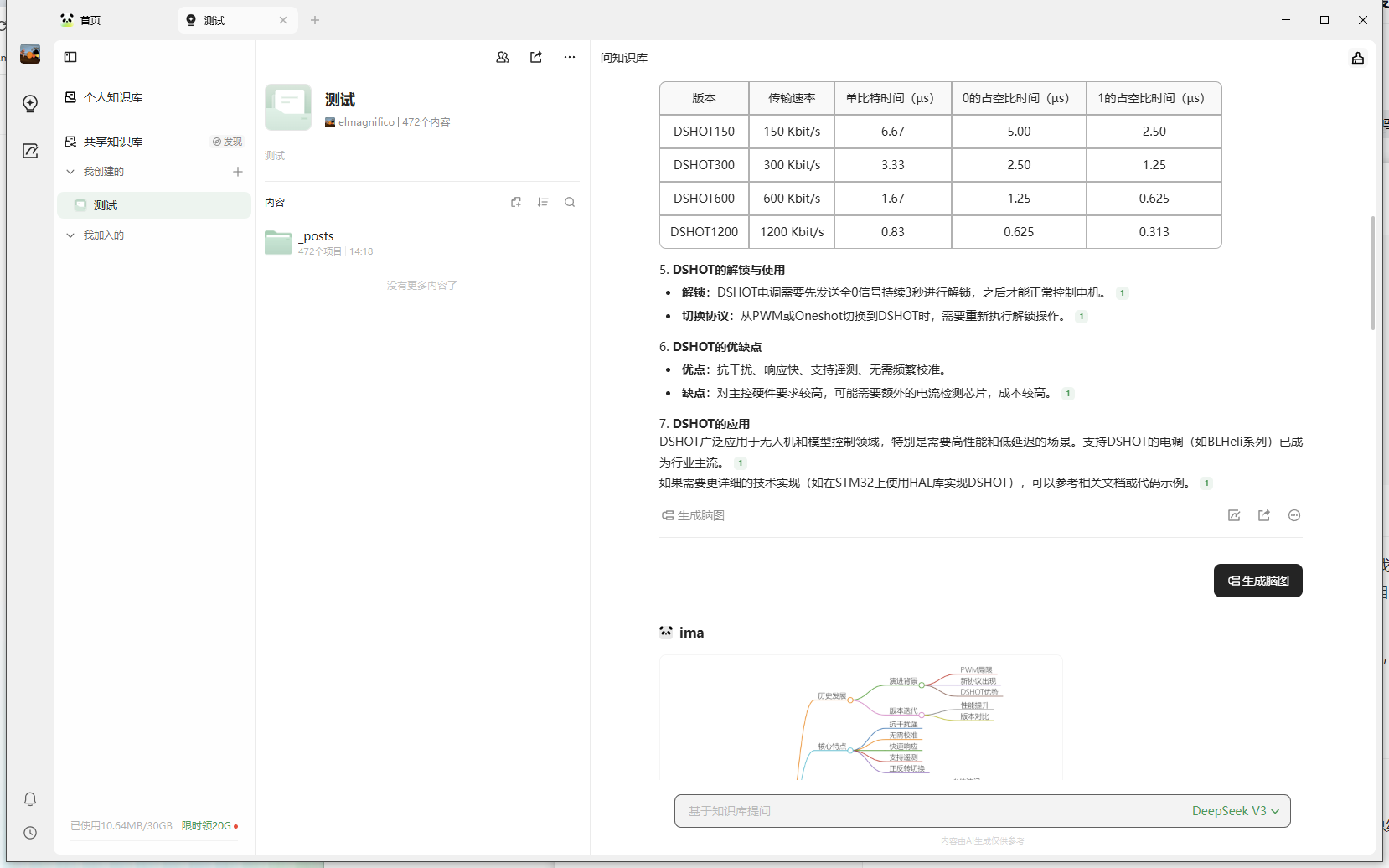

Foreword 我的blog基本就是我的知识库,都是一些比较冷门的知识点,我自己按照我的逻辑整理成的,之前就考虑过能不能结合我自己的知识库做一个AI,很久之前看过王登科的把自己的聊天记录做成了模仿自己说话语气内容的AI数字人,不过模仿语气我感觉不太需要,能正常提问回答出来我知识库的内容就够用了,语气什么的,客观就行了。 我也试过有道的、wolai的只能说在文档提问这一块还是有点挫,特别是wolai的基本是垃圾,不知道做这玩意干啥用,完全没有可用性。 iMa https://iMa.qq.com/download/ 最近听说腾讯的iMa知识库,试用一下,发现挺不错的,内容总结也可以,导入速度也挺快的,有原始的markdown文档就可以。 上手很简单,直接把我的blog的post全都..

更多