一日一技:如何正确渲染大模型返回的Markdown?

摄影:产品经理简单做个家宴我们经常让大模型返回Markdown格式的文本,然后通过Python的markdown库把文本渲染成HTML。但不知道大家有没有发现,大模型返回的Markdown并不是标准的Markdown。特别是当返回的内容包含列表时,大模型返回的内容有问题。例如下面这段文本:1234**关于这个问题,我有以下看法*** 第一点* 第二点* 第三点你粗看起来没有问题,但当你使用markdown模块去把它渲染成HTML时,你会发现渲染出来的结果不符合你的预期,如下图所示:这是因为标准的Markdown对换行非常敏感,列表项与它上面的文本之间,必须有一个空行,才能正确解析,如下图所示:不仅是空行,还有多级列表的缩进问题。标准Markdown的子列表项缩进应该是4个空格,但大模型返回的子列表缩进经常..

更多

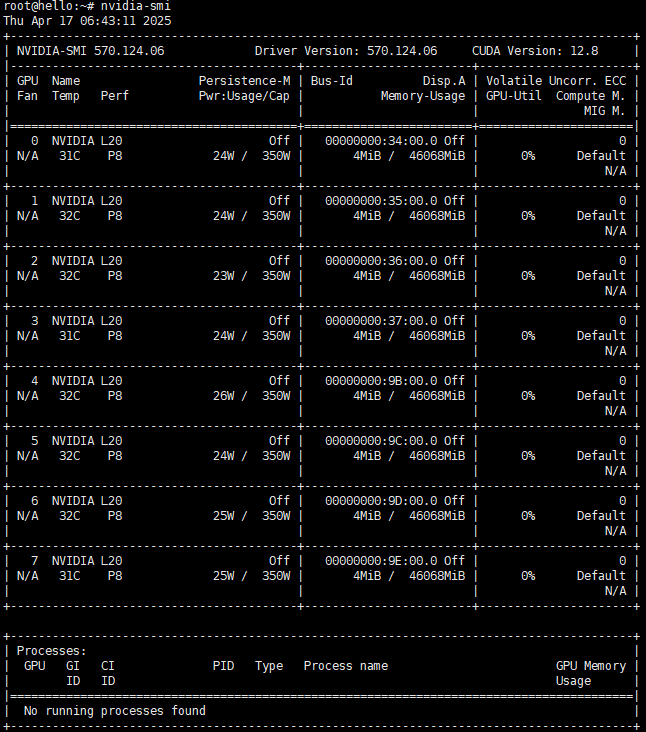

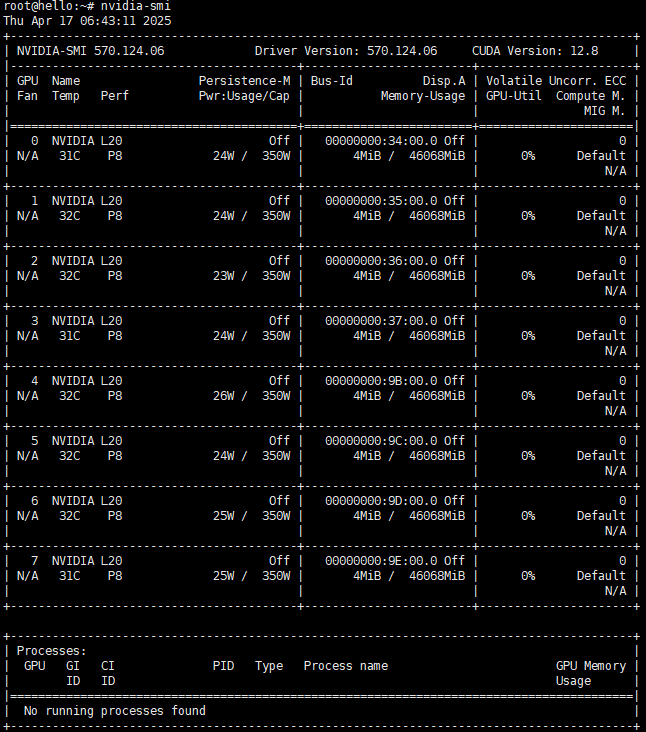

DeepSeek-671b-Q4部署

Foreword DeepSeek火了这么久,总算轮到我来部署一下了,部署小模型的挺多的,但是接近满血的大模型的好像很少,遇到的问题也难得有人说。 DeepSeek 设备需求 浪潮 NF5468M6 GPU服务器 CPU:2x6330(2G,28C/56T,42MB,Turbo,205W,3200),2x2400¥ 内存:32x64G DDR4 3200 RDIMM ECC,32x500¥ 硬盘:5x1.6TB SSD NVMe U.2 2.5寸 混合型,5x900¥ 阵列卡:Intel/英特尔 VROC KEY VROCPREMM0D U.2 NVME 阵列 RAID 0/1/5/10激活卡 高级版,1300¥ 网卡1:迈络思 MCX556A 100G 双口网卡,1500¥ 网卡2:X710双..

更多

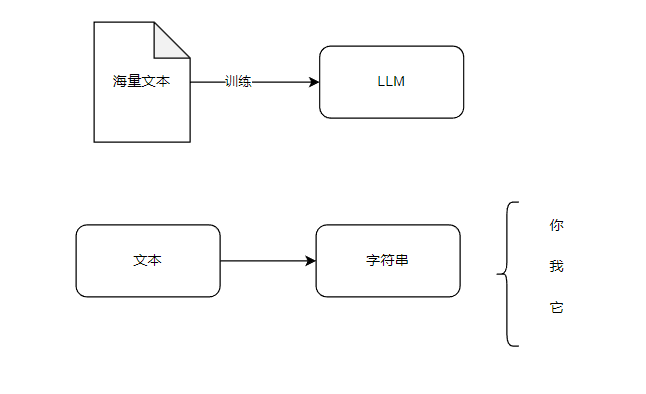

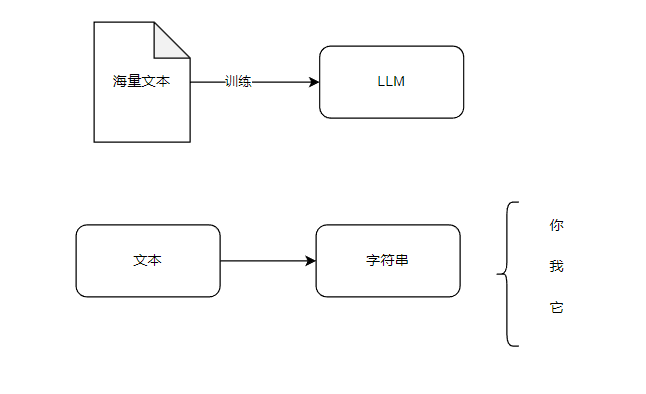

AI大模型笔记

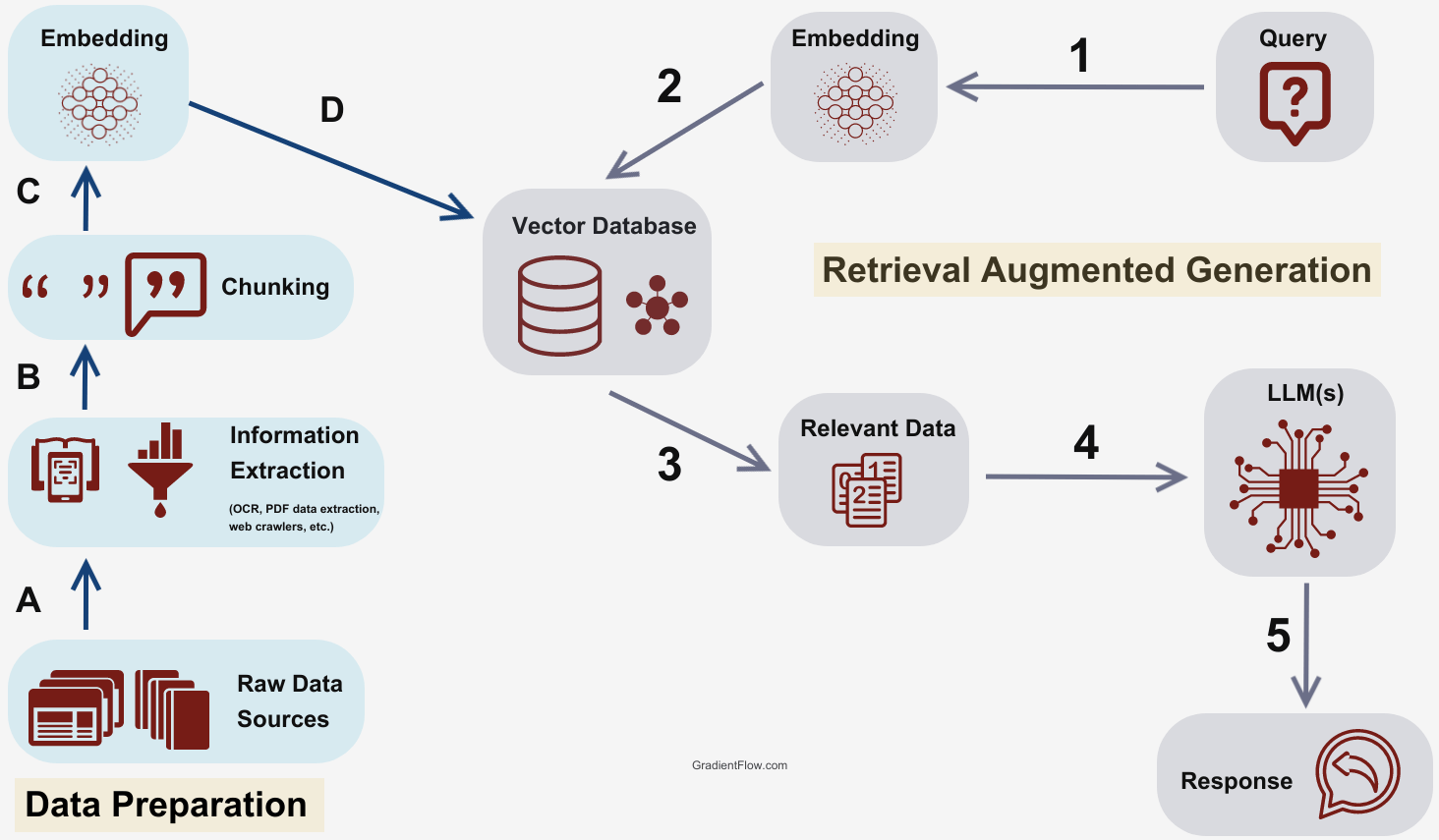

Foreword 记录一些AI相关的流程或者是运行逻辑 AI Transform Transform的机制 Benchmark 做一个新模型的时候,最好先建立好一个Benchmark,用来评估当前模型的性能,从而有一个准确的优化方向 微调 微调的流程 微调的后期,要么是有一个专家模型负责评估,要么就是有一个RLHF的反馈环境,不断对模型进行微调,这样整个模型就在不断进化中,效果就能越来越好。 当这个累计到一定时间或者数据以后,就可以考虑直接全参数微调,变成一个新模型 RAG 某些应用既可以通过RAG实现,也能通过微调实现,RAG相当于是外挂一个知识给模型,比较灵活,但是RAG的实现细节也有很多东西要考虑。 Denoise 本质上Diffusion就是..

更多

聊聊大模型推理加速:从数据到系统的技术概要

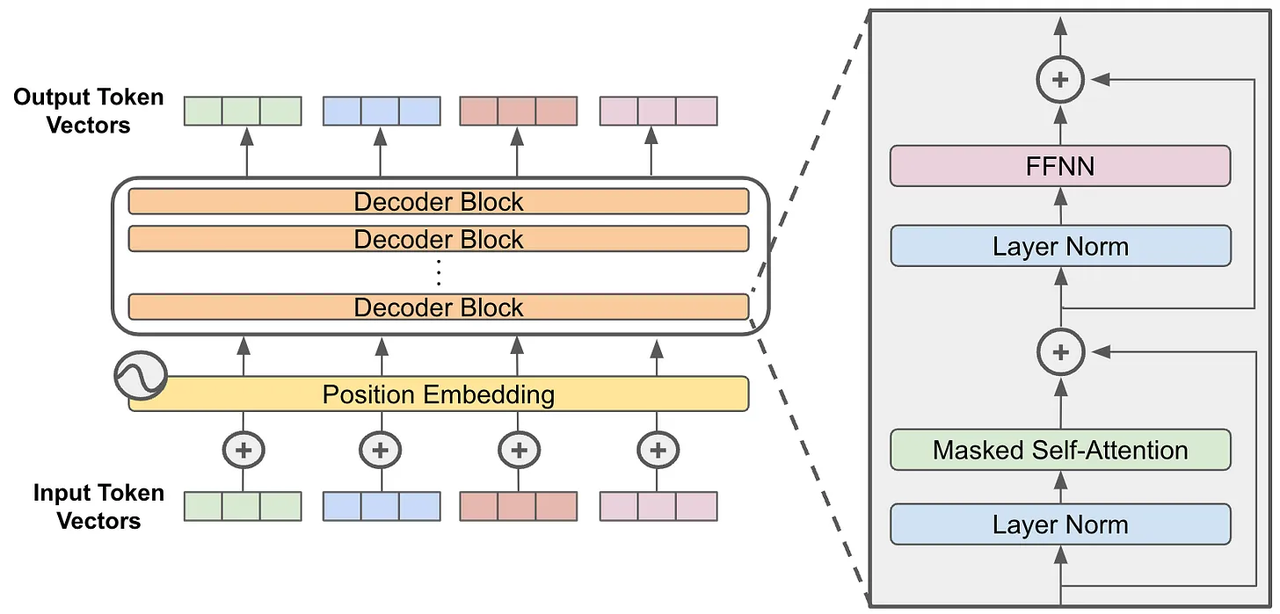

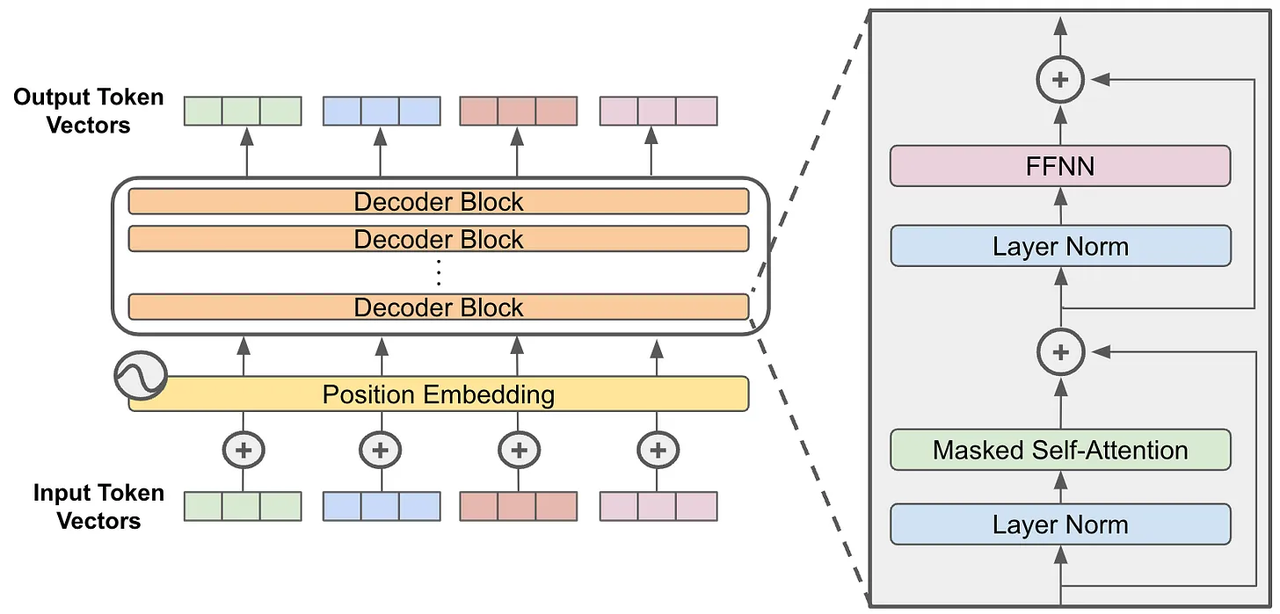

随着 LLMs 在各行各业的应用,如何在保证模型性能的前提下实现高效推理已成为重点挑战之一。前言主流的 LLMs 在算法架构上基于 transformer 的 decoder-only 架构,核心任务是 next token prediction,在推理过程中,模型需要依次生成每个 token,这种自回归生成的特点会增加推理延迟。并且从参数量上模型可分为不同规模,即使是小模型,其对计算资源和内存资源也有较高要求。为了应对这些挑战,学术界和工业界提出了多种优化方案。本文将介绍了若干 LLMs 的推理加速相关的关键技术。如有错误或不准确之处,欢迎指正。正文推理阶段概述推理阶段是模型接收输入并产生输出的过程。与训练阶段不同,推理阶段不需要计算梯度和更新参数,只需要完成前向传播计算。在推理过程中,由于自回归生成的..

更多

聊聊 Rerank:从 BERT 到大模型的技术旅程

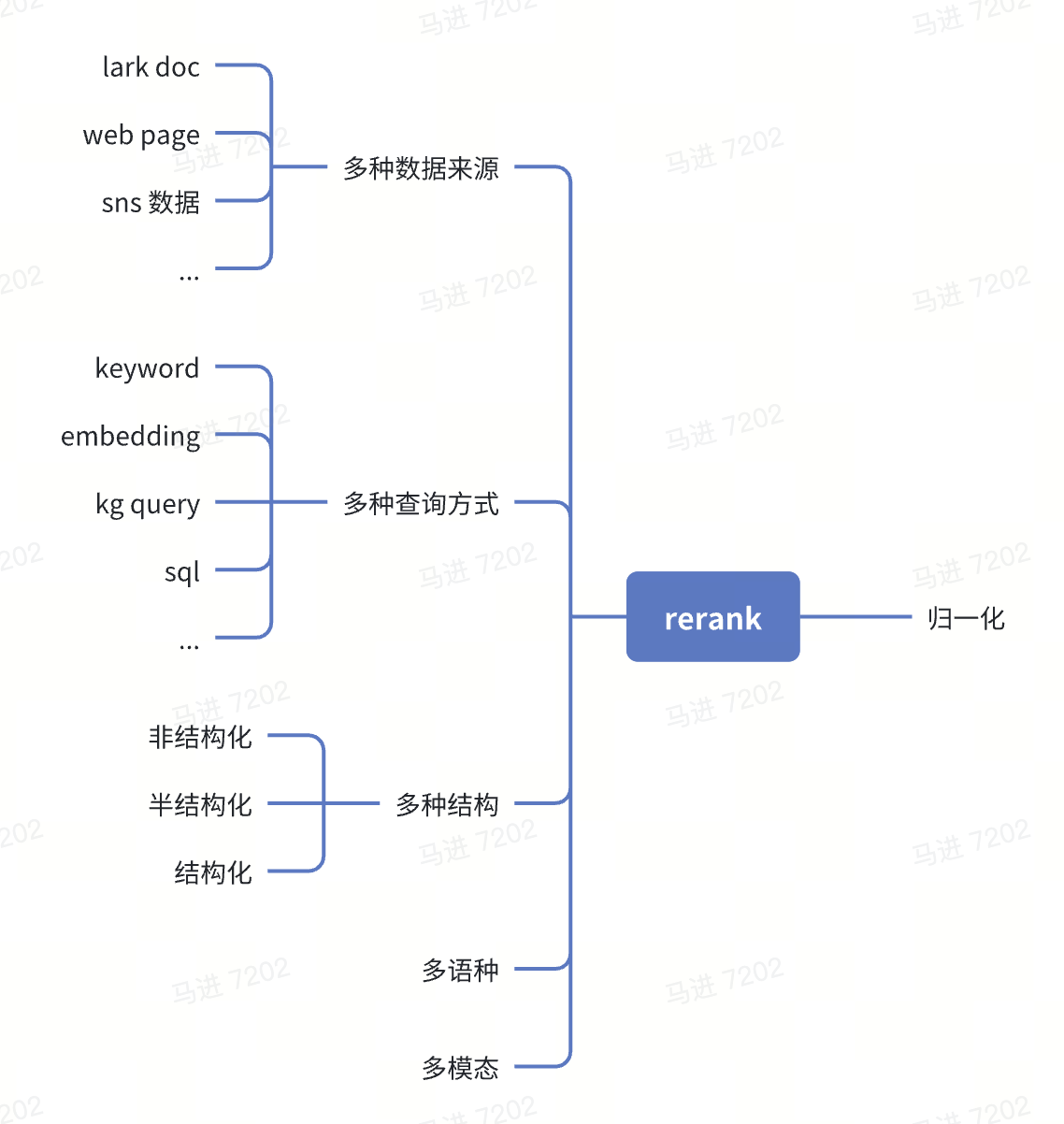

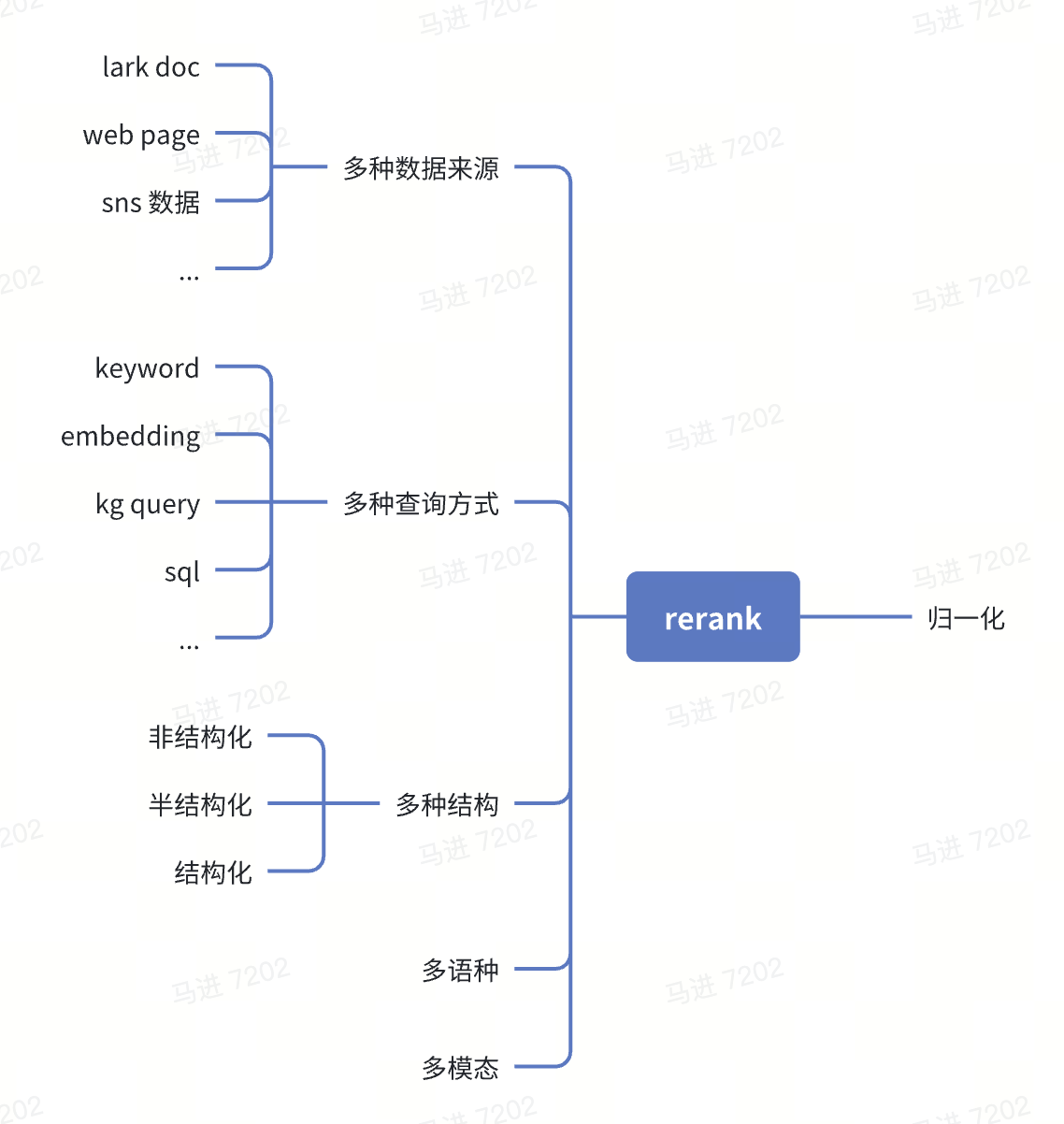

从搜索引擎到大语言模型,Rerank 技术一直在默默发挥着”最后一公里”的关键作用。前言在 NLP 场景中,Rerank 作为一个关键环节,承担着对多路召回、多数据来源、多模态、多结构等不同类型数据的归一化和精筛作用。它能有效地整合和优化各类召回结果,对提升检索系统的整体性能至关重要。本文将介绍 rerank 相关的技术概念、业界进展,以及对业务 产生价值的可能性。 Rerank-从 BERT 到大模型的技术旅程/overall.png 正文什么是 RerankRerank 并不是新兴的技术,其发展历史可追溯到搜索引擎,其历程可浓缩为 3 个主要阶段: Rerank-从 BERT 到大模型的技术旅程/timeline.png 一句话介绍:Rerank 是一种对初步检索结果进行重排序的优化技术,以提..

更多

RAG 基本应用——Beancount 记账效率优化

本文来自于一个手工记账博主的脑洞大开,尝试通过向量数据库和 RAG 来想办法让自己少打几个字。顺便宣传一下最近开源的记账 bot. 背景 自从 2020 年将记账系统迁移到 Beancount 后,我就开发了一个 Telegram Bot 来辅助我记账。通过它,我可以使用 {金额} {流出账户} [{流入账户}] {payee} {narration} [{tag1} {tag2}] 的文法来快速生成一条交易记录并落库。虽然后来将这个 Bot 迁移到了 Mattermost 上,但四年以来,核心逻辑并没有做任何改动。 最近经常骑车去打球,每次骑完车之后总需要掏出手机去记账,输入诸如 1.5 支付宝 哈啰单车 自行车 的文本。虽然已经手动记账记了七年,但完全相同的内容记得次数太多了,也难免会有些枯燥。 ..

更多

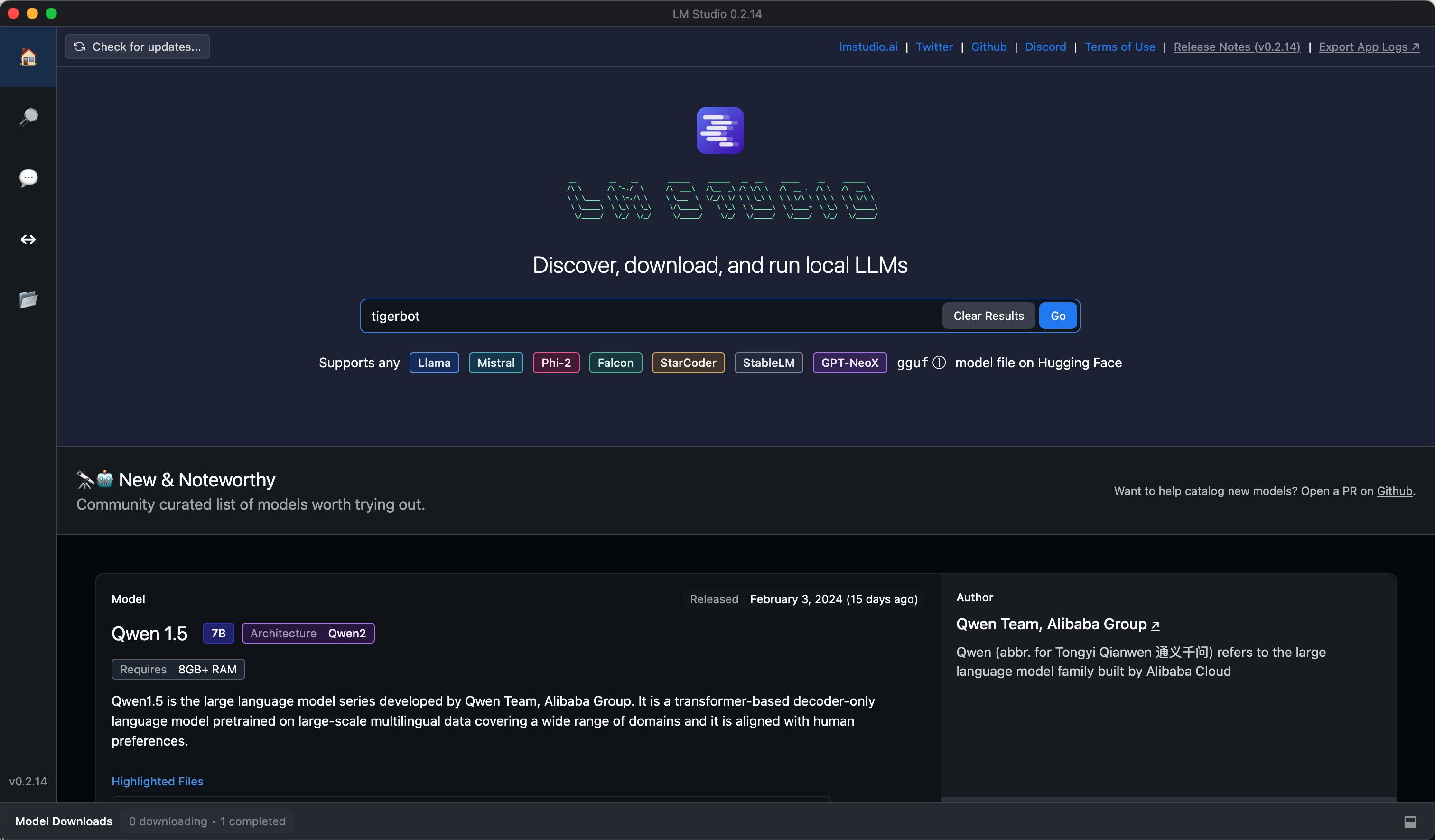

一日一技:三分钟离线运行开源大模型

经过一年多的发展,各种开源大模型现在已经相当不错了。国产的Qwen 1.5的生成效果已经能满足一些日常使用。有一些同学可能之前一直在用网页版的ChatGPT、Kimi Chat、文心一言或者通义千问,那么你可能会遇到如下一些问题:网络问题。例如ChatGPT需要特殊的网络才能访问。审查问题。国产大模型会大量屏蔽关键字,有一些你觉得完全没有任何问题的回答,它会告诉你不符合法律规范,不能回答。不能自定义模型,网页版的这些大模型,你没有办法做微调,难以自定义内容。当你花了大量时间设计了一个高级Prompt,把模型洗脑成了猫娘,结果第二天它又不能用了。隐私泄漏问题,担心大模型的开发商把你问的问题和上传的信息挪作他用。当你被这些问题困扰,那么你可以考虑离线运行开源大模型。完全不需要网络,因此不存在隐私泄漏的问题。你..

更多