hdfs 实时 Decommissioned 节点

前置工作在hfds-site.xml 中确保 dfs.hosts, dfs.hosts.exclude 都存在.假设为 /tmp/includes ,/tmp/excludes上下线节点只需要修改 Namenode 的 /tmp/includes ,/tmp/excludes 文件, 也可以同步修改所有NN, DN节点下线节点假设要移除的节点为 dn1, dn1 需要同时存在于 /tmp/includes ,/tmp/excludes执行 hdfs dfsadmin -refreshNodes 即可不重启 hdfs, 将 DN节点下线检查 hdfs web ui, 即可看到节点变为 Decomission 或者 Decomissioning 状态重新上线节点将 dn1 从 /tmp/excludes 中移..

更多Hadoop手动切换Namenode

NN 名称定义于 hdfs-site.xml 中1grep dfs.ha.namenodes.hdcluster ${HADOOP}/etc/hadoop/hdfs-site.xml查询 NN 节点1hdfs getconf -namenodes查询 NN 状态12hdfs haadmin -getServiceState namenode1hdfs haadmin -getServiceState namenode2手动切换1hdfs haadmin -failover -forcefence -forceactive namenode2 namenode1or1hdfs haadmin -transitionToActive namenode2HA 集群手动切换存在脑裂的可能性, 推荐在目前 Acti..

更多

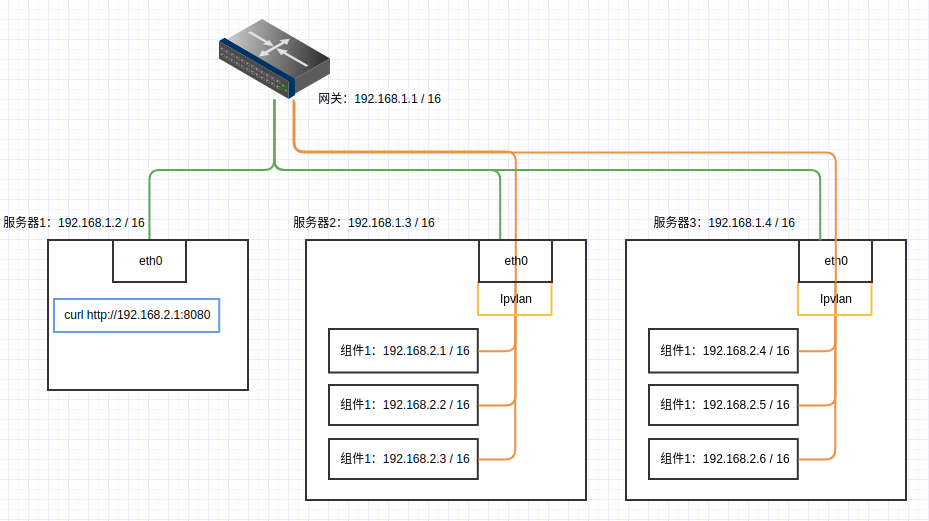

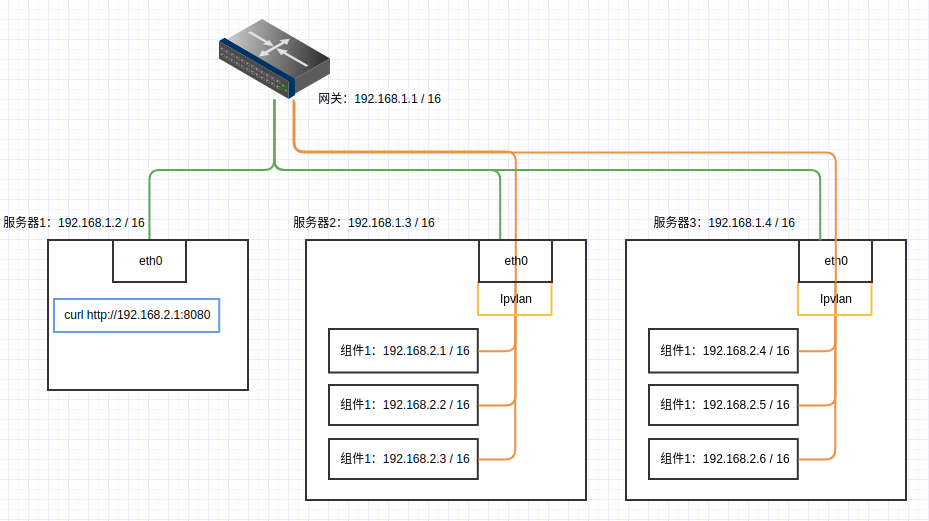

自建大数据分析集群

老项目老项目了这些都是。大部分都是十年前就出现的工具。感叹真是经久不衰。最近服务开发中,为了节约成本,弄了两个服务器,希望搭建一套数据分析平台,验证项目流程。查了很多资料对这些平台的搭建都非常简略,过程也是复杂,对新人很不友好,我也算是整理了一下相关的内容。简化服务搭建流程。得益于Docker的容器化,整个数据平台搭建起来非常方便整个过程里面,包含以下工具的搭建:HDFS,主要是用来存储数据YARN,提供资源调度,实现MR计算Hive on MR,基于MR的SQL引擎, 性能堪忧。也有基于Spark的,但是没有找到版本对应的公共镜像,就放弃了Spark Standalone,分布式计算框架,有基于YARN或者HIVE的版本,为了依赖纯粹,使用了独立集群Kafka on Kraft,为了依赖纯粹,使用了Kr..

更多